手机部署DeepSeek R1:没有网络也能用|开源免费|无限使用!安卓+iPhone一次搞定

前言

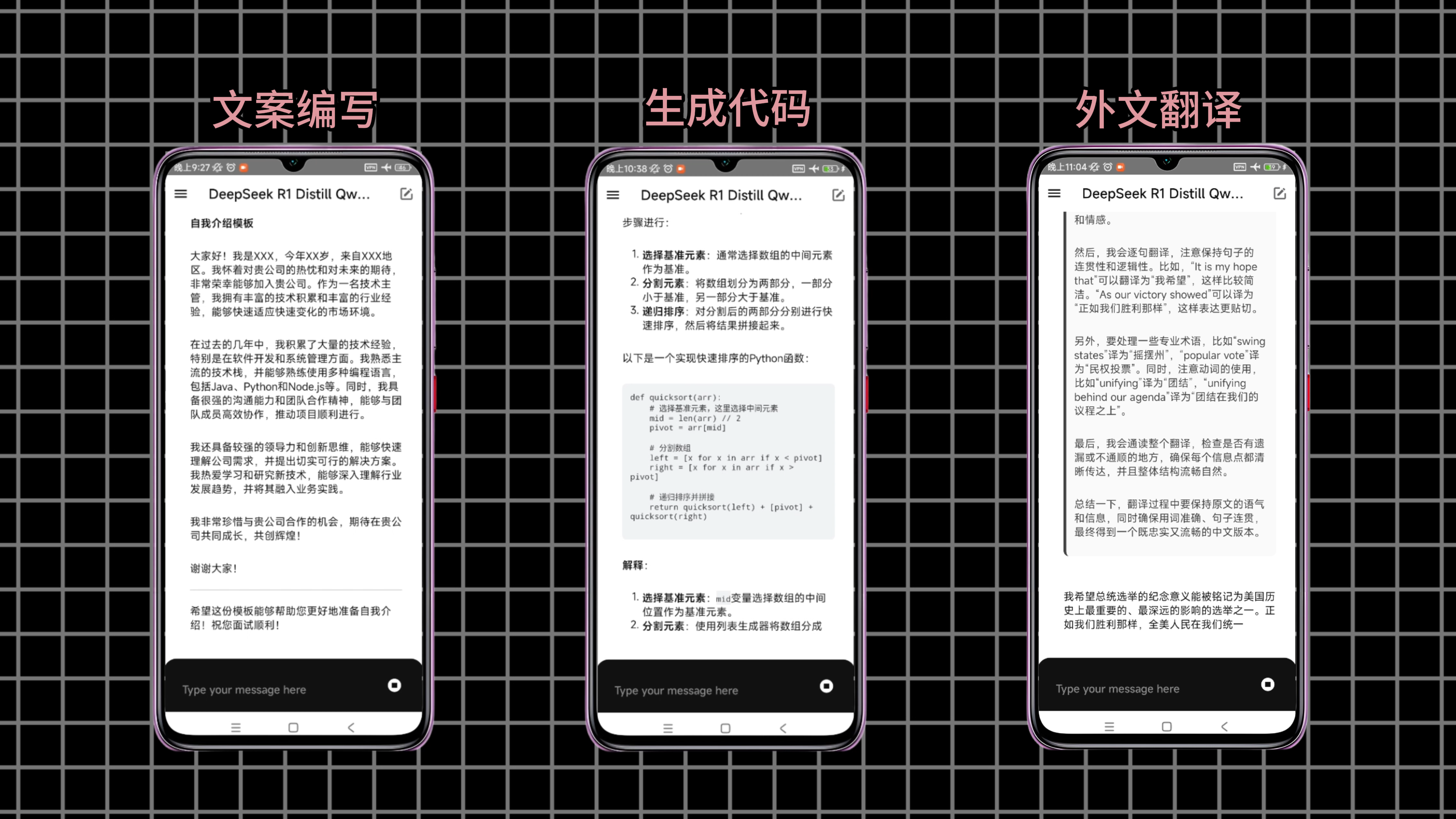

这是一个部署在手机上的,DeepSeek R1模型。有了它,你就相当于有了一个,可以随时随地、无限免费使用的。本地AI助手,即使在没有网络的情况下。你照样可以,使用它来完成:编写文案,生成代码、翻译外文,等等各种工作。

而想要在手机上,部署这样一个AI模型,只需要几分钟,非常的方便。并且对手机的配置,没有要求,市面上常见的手机,基本都可以满足。下面我们就来,为大家介绍,如何在自己的手机上,部署这样一个DeepSeek R1模型。

部署

安装PocketPal-AI

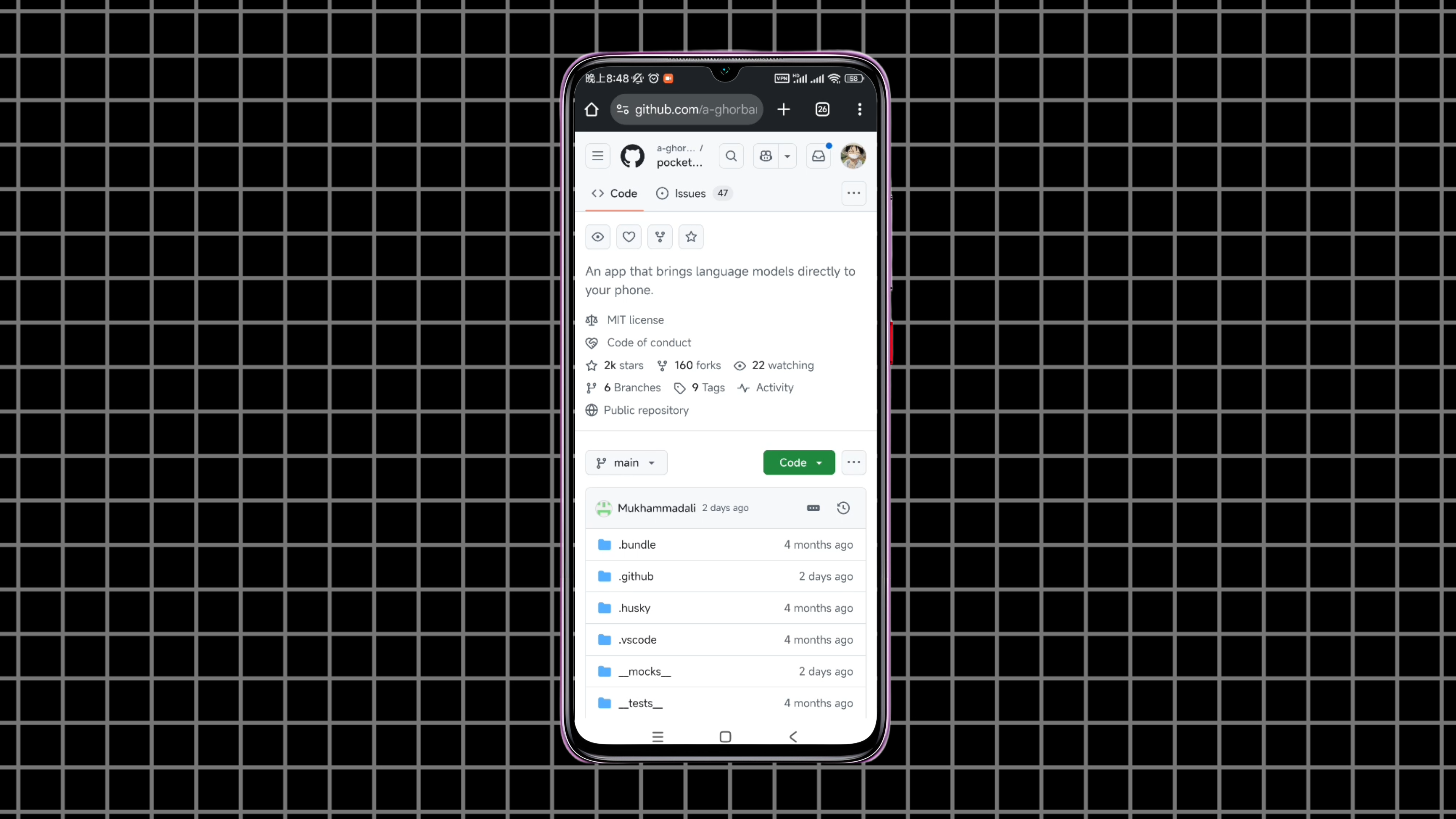

首先我们需要在手机上,安装一个AI管理软件。这里我们选择使用这个,PocketPal-AI,也叫做口袋AI。它是一个开源免费的手机端,AI管理和聊天软件,同时支持安卓和iOS,2种系统。在安卓系统上,安装口袋AI,可以通过Google Play来安装。直接搜索软件的名字,然后安装就可以了。

但是这种方式,在国内的话,需要使用梯子。如果没有梯子,也可以使用APK文件来安装。口袋AI的apk文件,可以在它的GitHub项目那里下载。或者也可以使用,文章下方提供的,网盘来下载。

如果是iOS系统的话,直接在Apple Store中安装就可以了。

加载DeepSeek模型文件

好了,安装完口袋AI后,下面我们来继续介绍,如何把DeepSeek R1,加载到口袋AI中。接下来的操作,我们直接使用,安卓系统来进行演示。IOS系统的操作流程,和安卓系统是完全一样的,直接照着来就可以了。

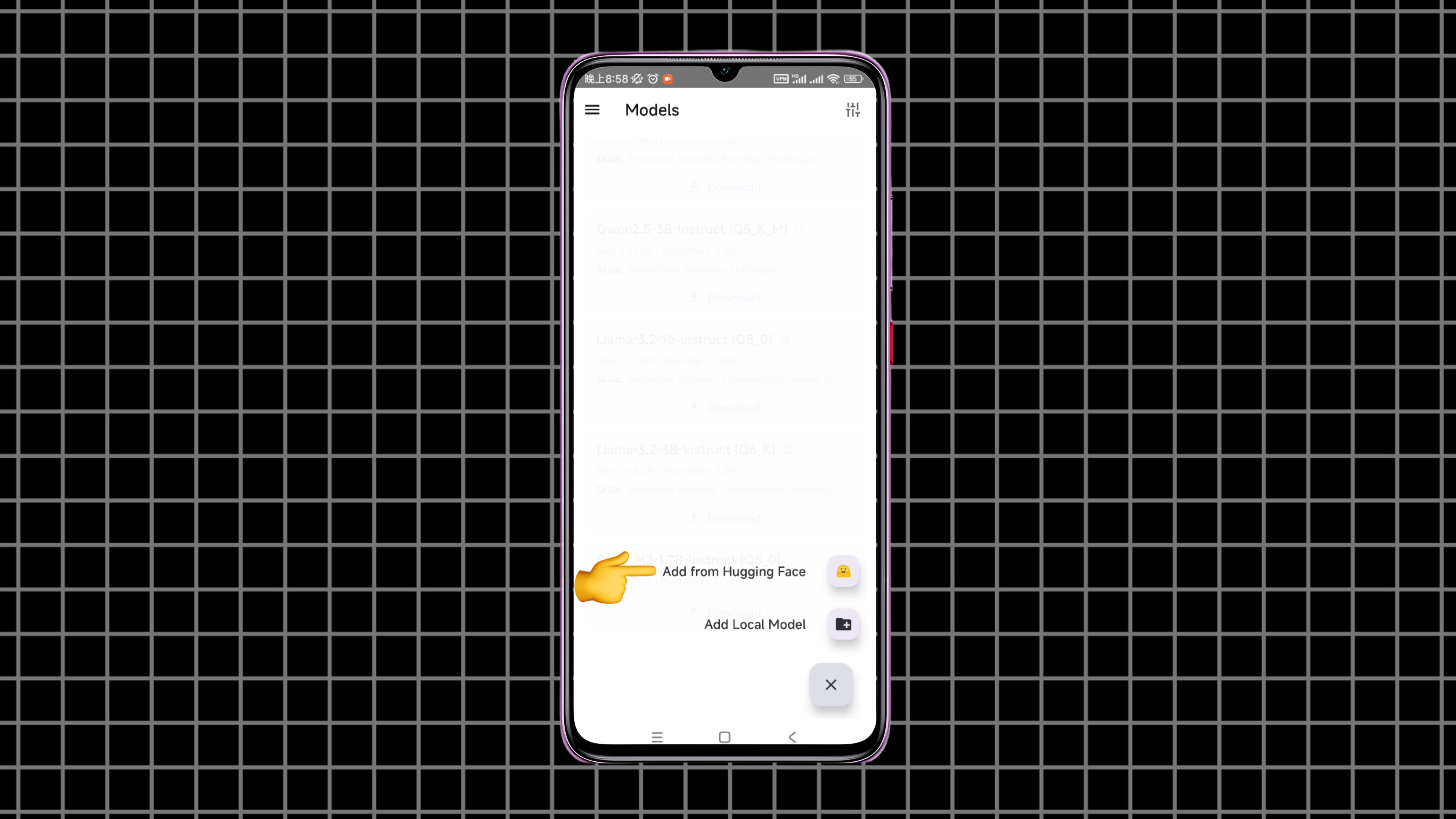

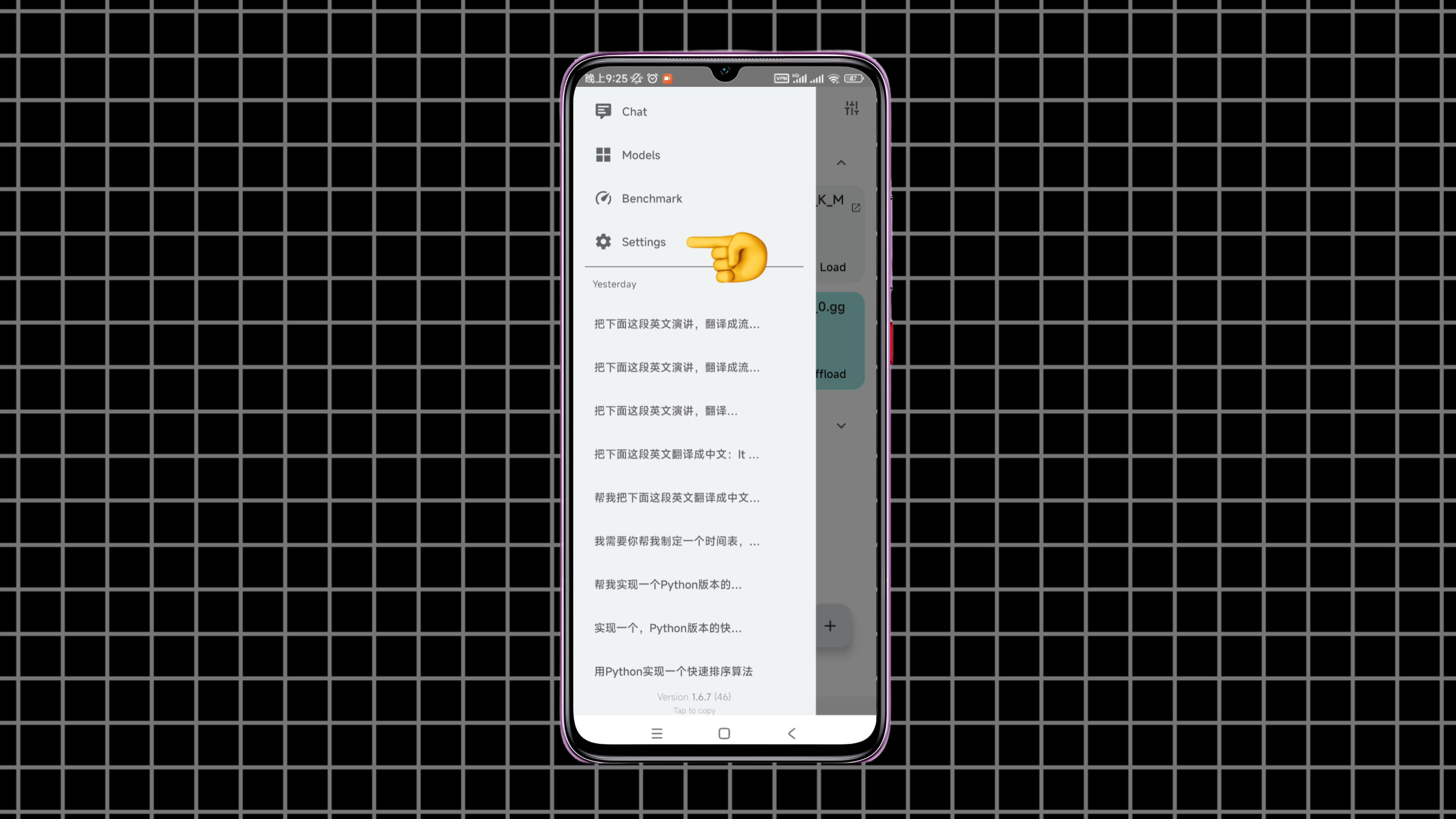

打开口袋AI,点击左上角的三道杠,然后点击models。我们点击右下角的加号,在这里可以选择,从hugging face来添加需要的模型。或者从手机上导入,已经下载好的模型。

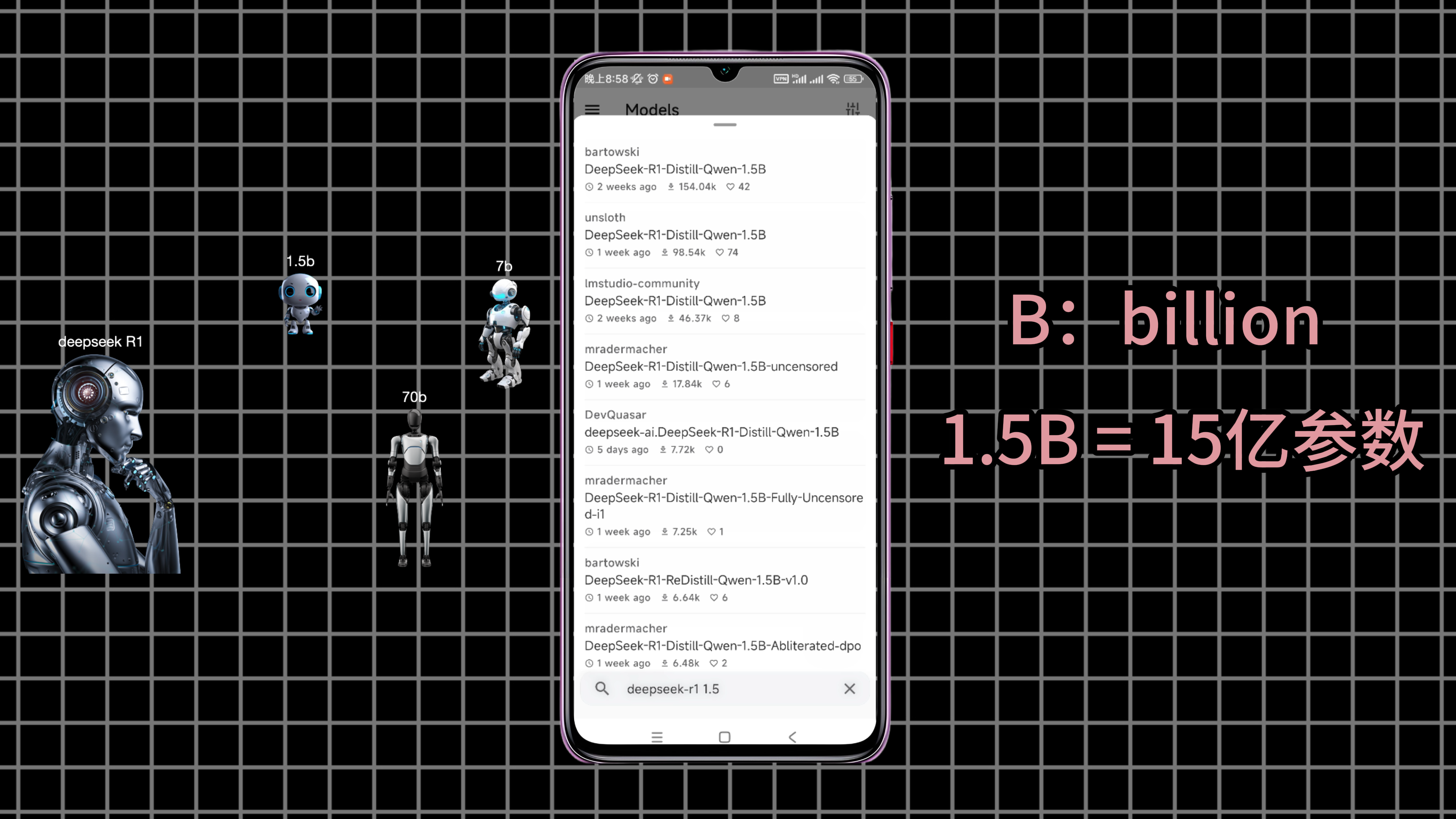

我们先来看第一种方式,在下面直接搜索我们需要的模型。这里我们选择部署一个,1.5B的DeepSeek R1蒸馏模型。

所谓蒸馏模型,在上一篇文章中,我们有介绍过。比如:满血的DeepSeek R1大模型,把它的知识传授给一个小模型。那这个小模型就是,DeepSeek R1的一个蒸馏模型。蒸馏模型的一个好处就是,方便部署,对机器的配置,没有太高的要求。而1.5B代表的是,就是这个蒸馏模型的参数量。B就是billion,所以1.5B就是15亿个参数。

DeepSeek R1的满血版是671B,也就是6700亿参数,普通的家用电脑是跑不动的。为此DeepSeek R1给我们提供了,1.5B、7B、8B等等,多个标准的蒸馏模型。蒸馏模型的参数量越大,推理能力就越强,当然对设备的要求也就越高。

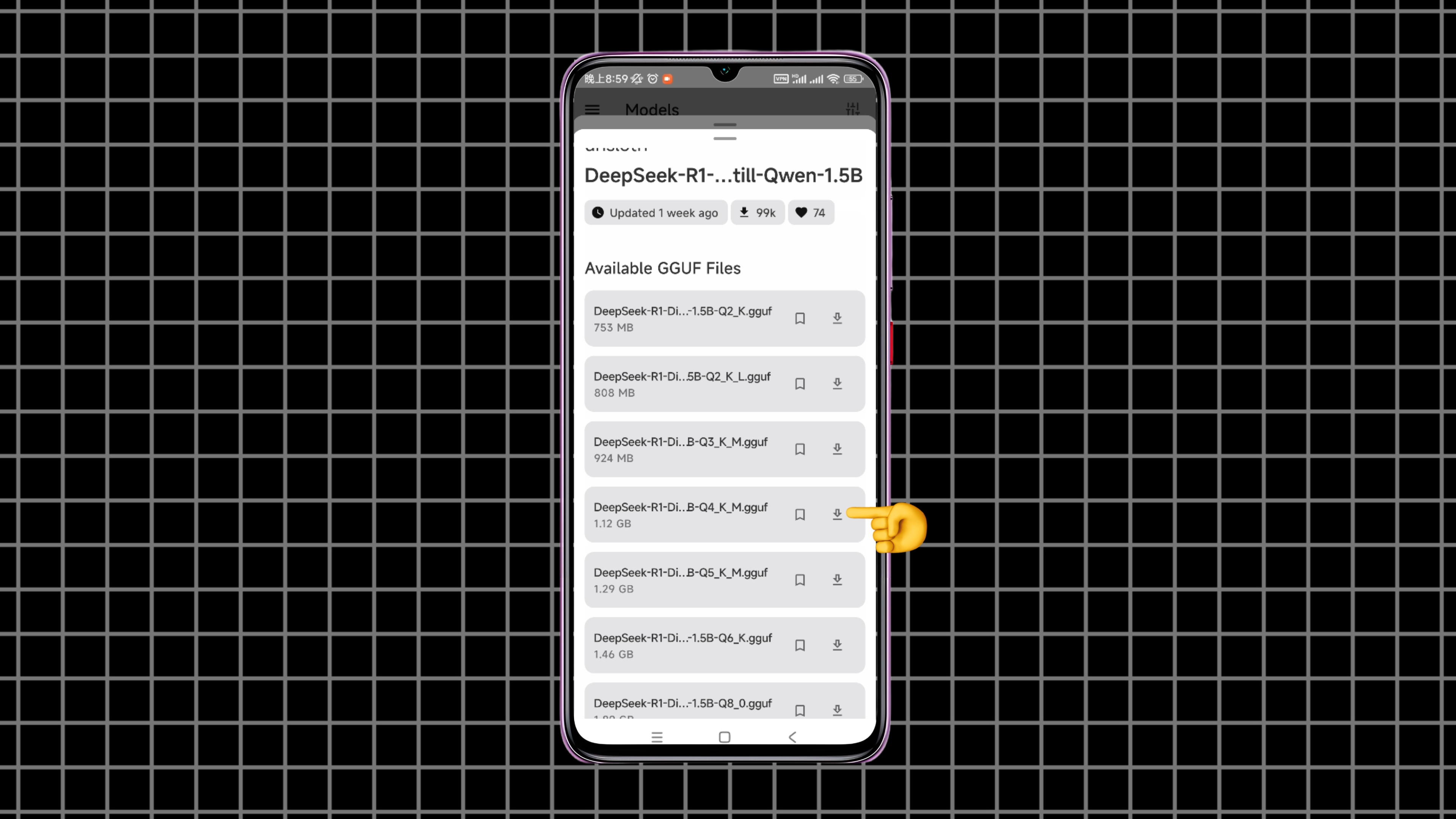

那由于手机的处理能力,相对有限,所以我们这里选择使用它的1.5B蒸馏模型。选择一个模型点击打开,可以看到同一个蒸馏模型。还根据量化精度,进行了划分,比如Q4就代表,模型的每个参数,使用4个比特来表示。而Q8则代表,模型的每个参数,使用8个比特来表示。显然Q8比Q4的精度更高,模型推理能力也更强,占用的空间也更大。

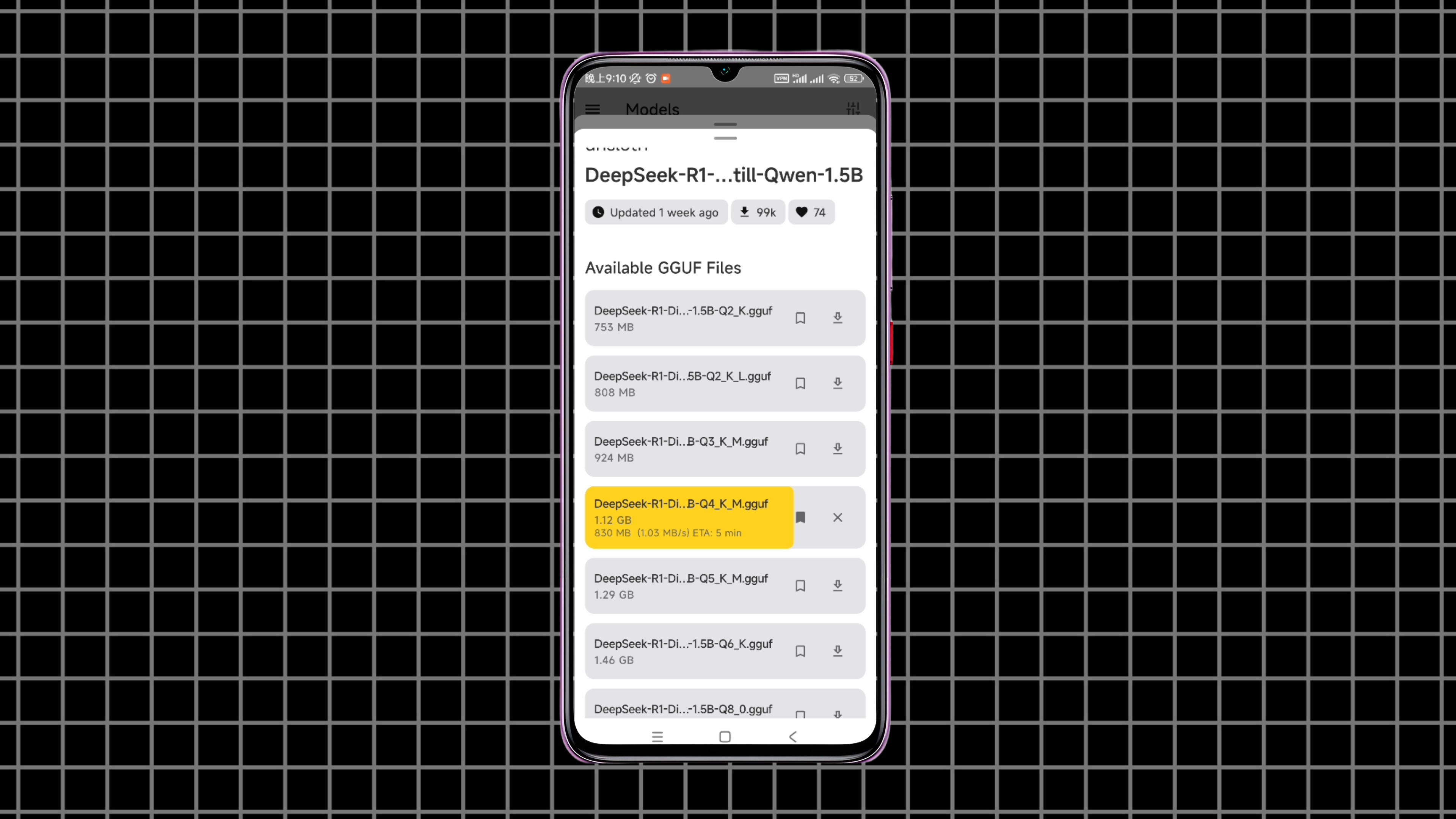

比如我们选择这个Q4的模型,点击下载按钮,等待模型下载完成。

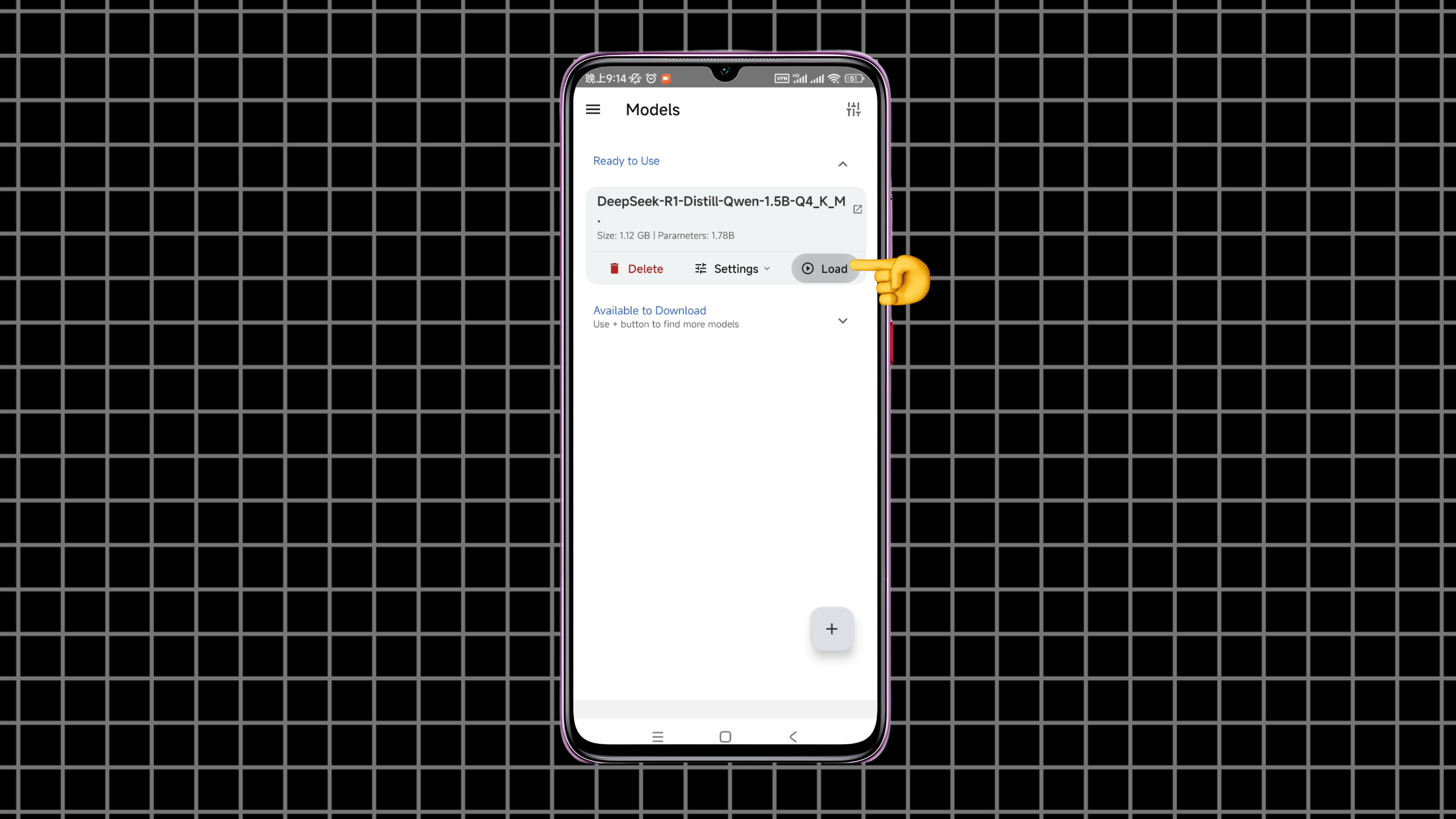

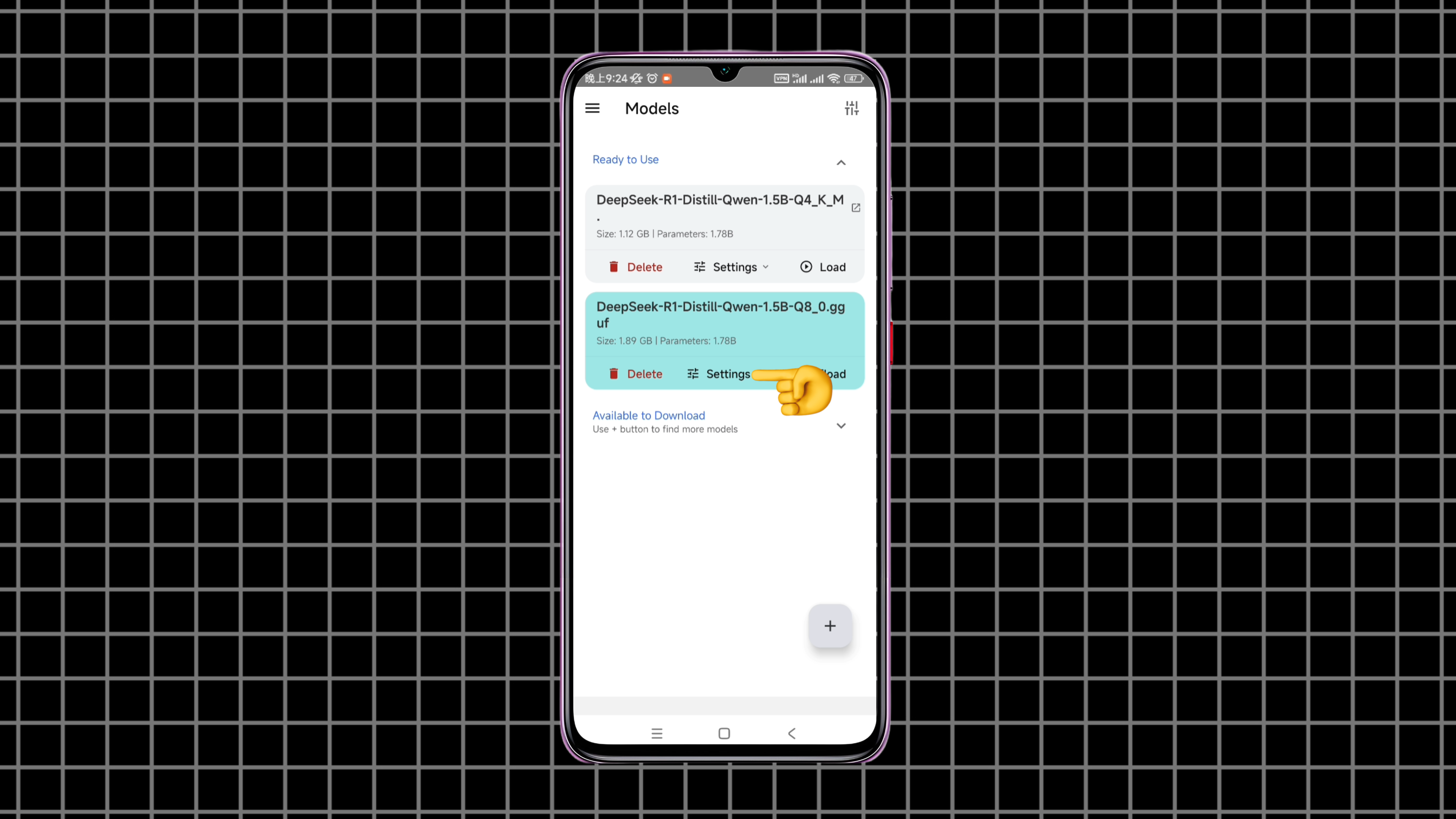

模型下载完以后,我们回到口袋AI的models里面,在这里就可以看到,刚才下载的模型了。点击这个load,就可以把模型加载进来,加载完成以后,它会自动跳转到聊天页面。在这里,我们就可以和这个,DeepSeek R1模型对话了。

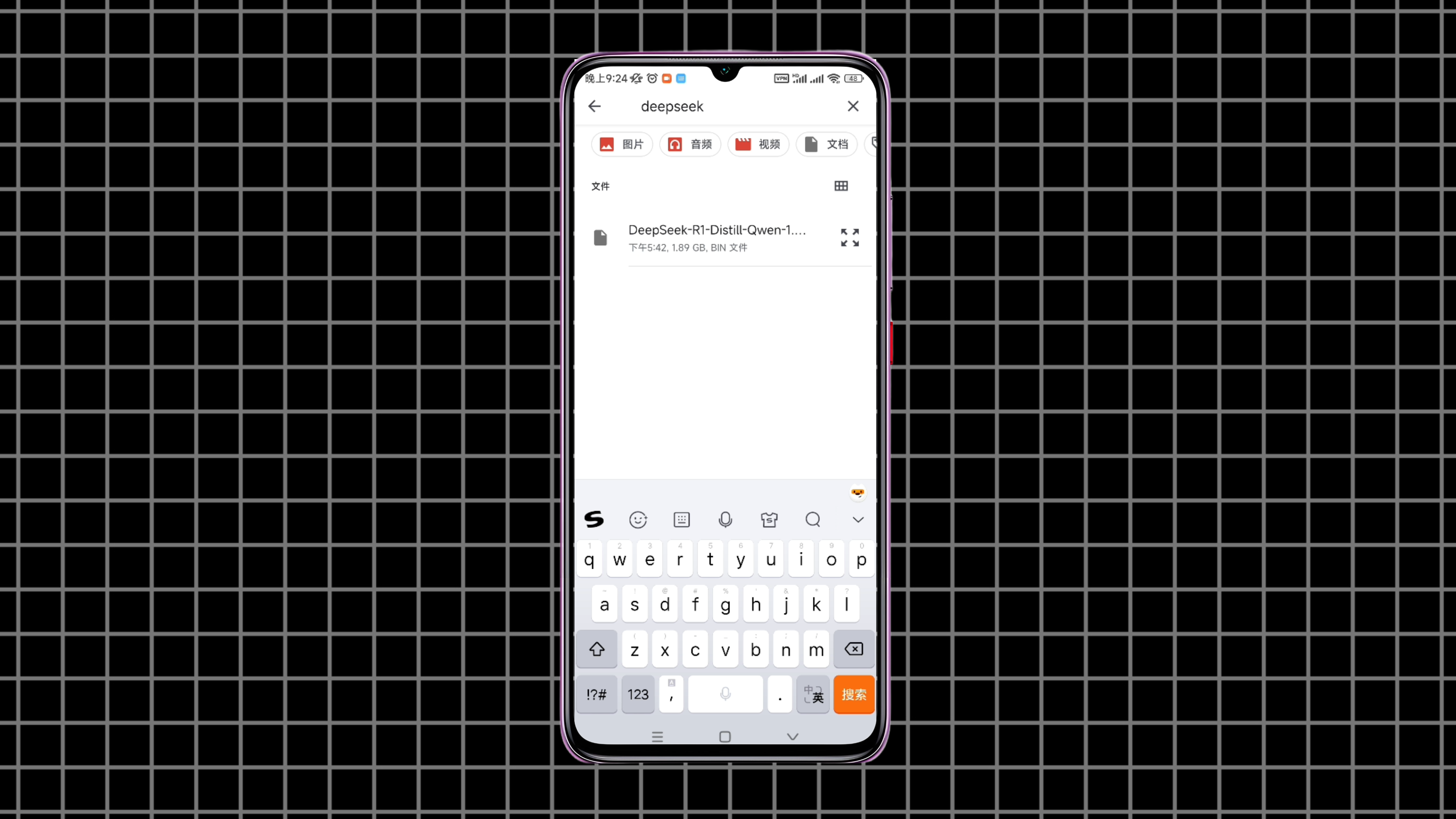

上面介绍的这种,添加模型的方式,同样需要有梯子才能访问,hugging face。如果没有梯子,也可以从手机上导入,提前下载好的模型文件。我们点击这个“add local model”,把手机上提前下载的模型文件,添加进去。可以看到,这个是一个Q8的,1.5B模型,大小大概是2个G。

点击load,把它加载进来。加载完成了后,它会自动跳转到聊天页面。在使用这个模型之前,我们还需要做一些设置。回到models,可以看到,它这里只能加载一个模型。这个Q8的模型,加载完成以后,原来那个Q4的模型,就自动解除加载了。

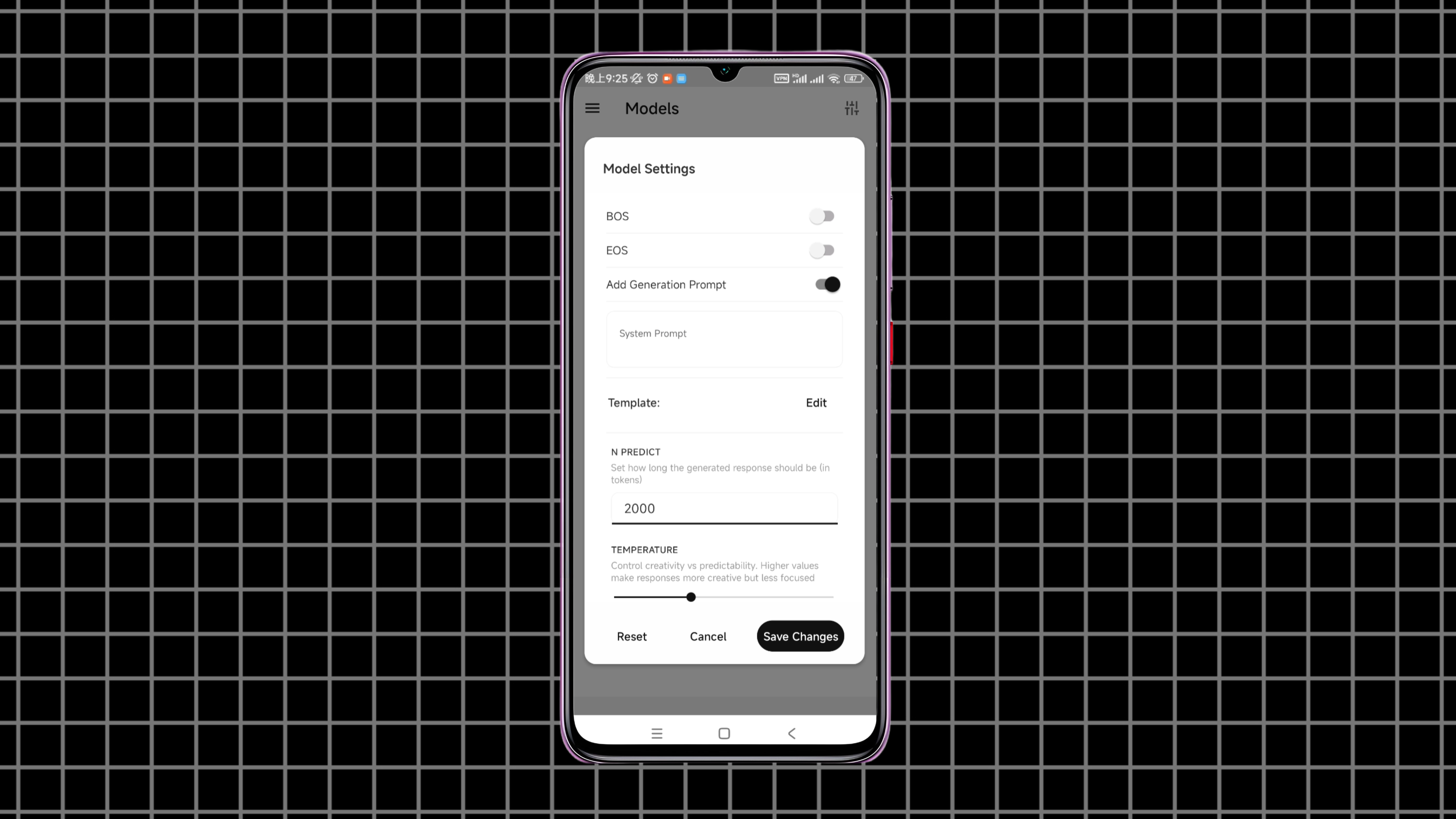

点击这个模型的设置,在这里,我们可以根据自己的需要,对模型进行一些配置。

比如这个N predict参数,它是模型每次运行时,生成的候选结果的数量。使用这个参数,模型每次会生成,多个可能的答案。并从中挑选出,最符合上下文,或需求的那个答案,这个参数可以适量调大一些。

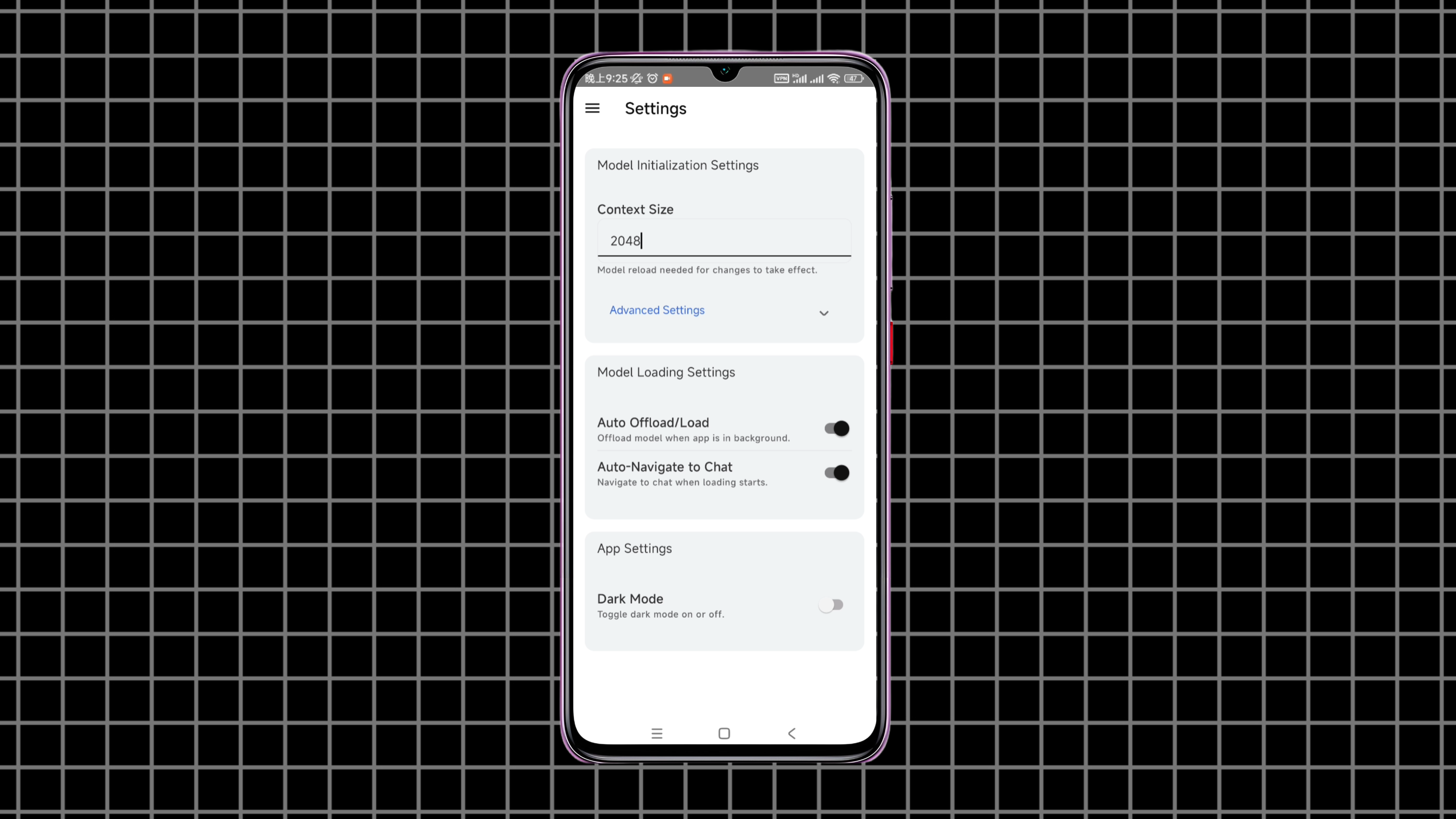

再有就是,App设置里面的,这个context size参数。

它是模型能够一次处理的,上下文长度,可以理解为模型的记忆大小。如果需要进行多轮对话,或长文本任务。可以把这个参数,适量调大一些。

使用DeepSeek R1

好了,设置完这些参数。下面我们就可以,来使用这个本地部署的,DeepSeek R1模型了。这里我们选择了3种使用场景,来进行演示。分别是:文案编写、代码生成和外文翻译。我们打开飞行模式,下面的操作,都在没有网络的环境下,来进行。

1.文案编写

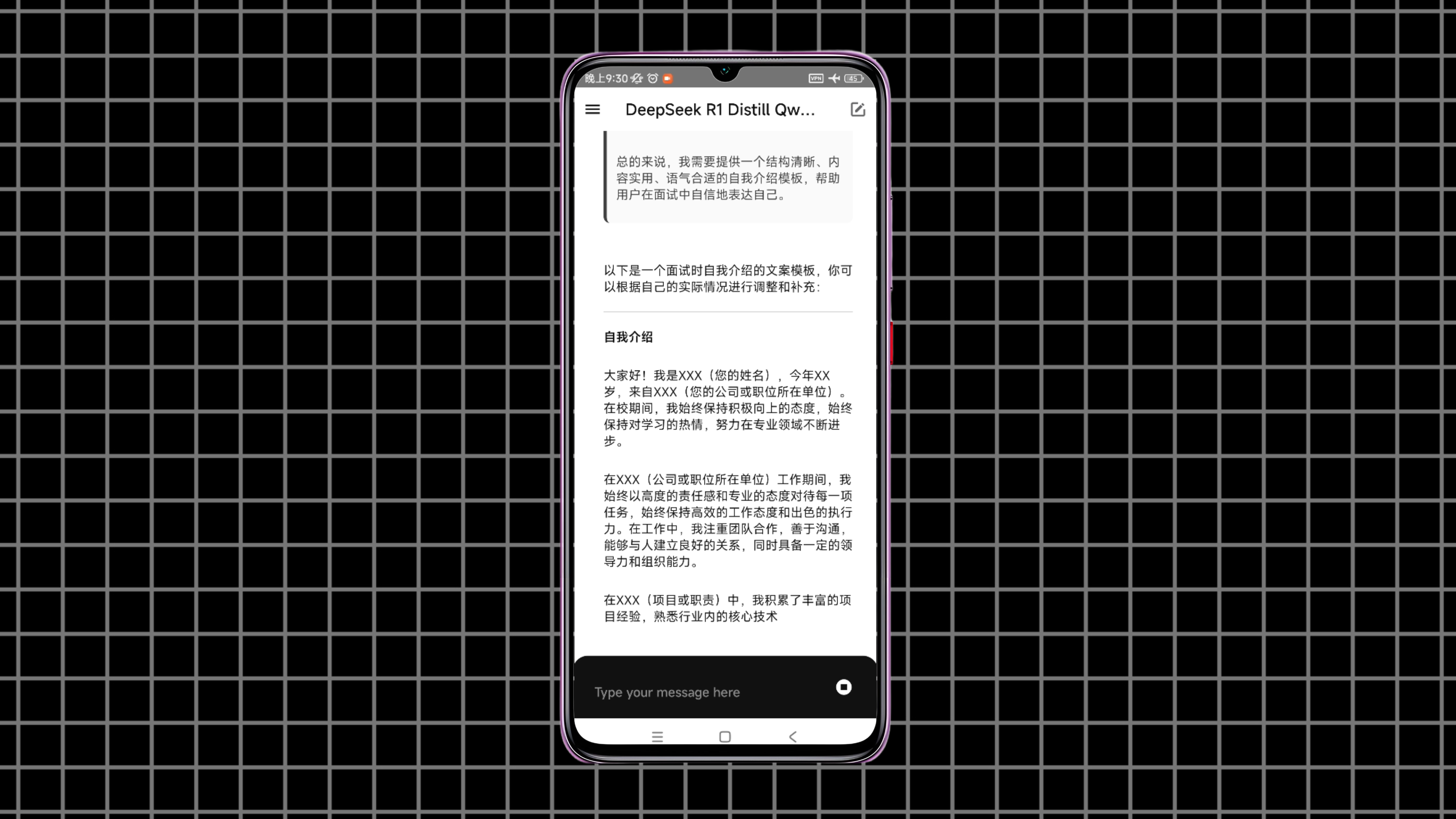

首先来看文案编写。打开聊天页面,我们让它来给我们编写一个,面试时自我介绍用的文案模板。首先它会给我们展示,思考过程,比如这类文案模板的结构,是什么样?

使用什么样的语气比较合适?以及需要注意哪些事项等等。然后它就给我们,编写了这样一个文案模板。看上去效果还不错,只需要再修改一下,就可以使用了。

2.生成代码

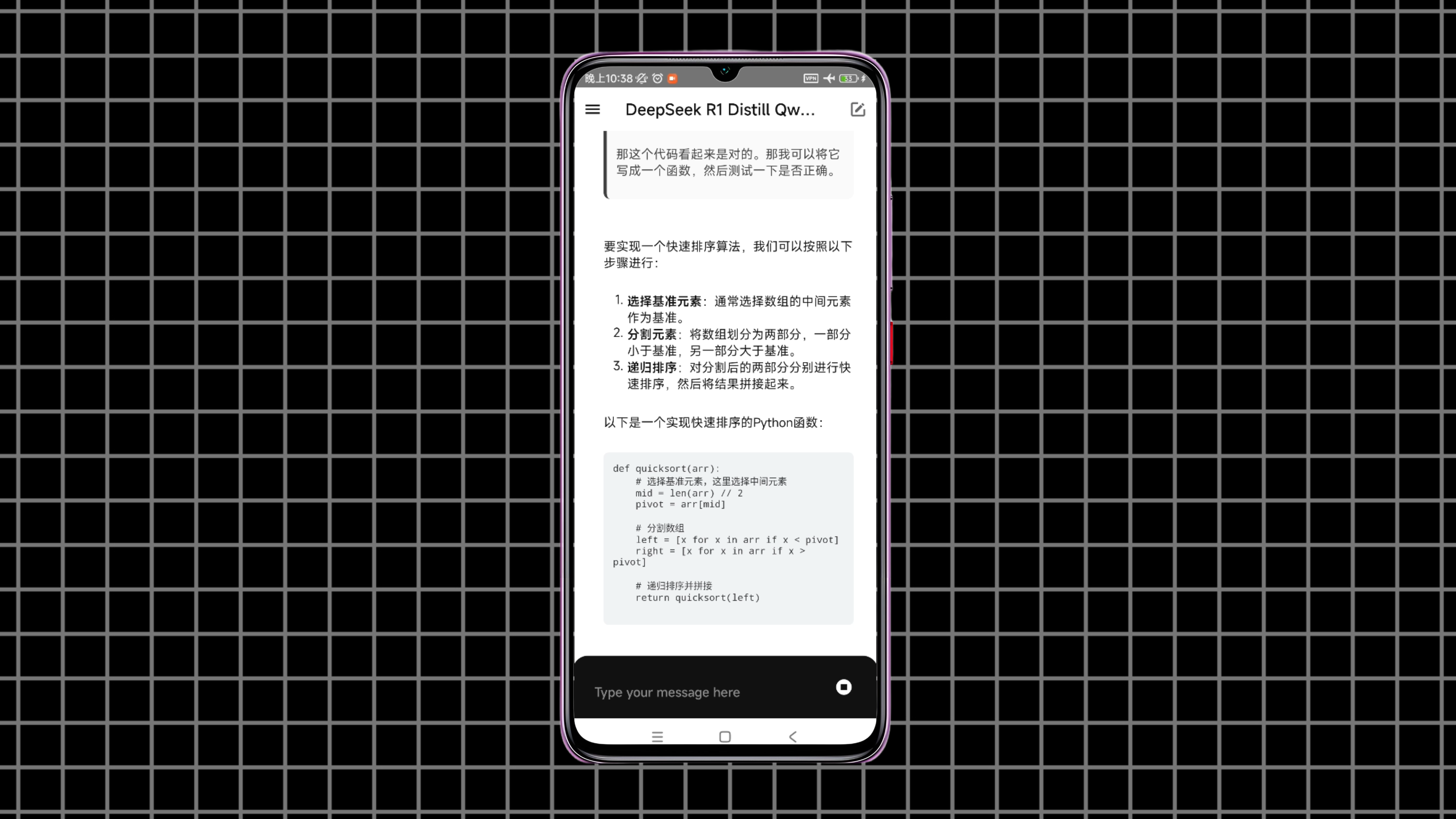

接下来,看一下它的代码生成能力。这里我们让它写一个,Python版本的快速排序算法。可以看到,它不只是,直接给出代码那么简单。而是从头到尾帮我们,梳理了一遍快速排序算法的原理,和实现的具体步骤。而且就连代码中,涉及到的一些边界条件等细节,也进行了详细的分析。

如果对代码中的某些地方不理解,还可以继续追问,它会给你一点一点解释清楚。这对于学习算法来说,简直就像有了一个,专业的,私人辅导老师。但是1.5B模型的能力,还是比较有限的。如果让它生成一些,稍复杂的代码,它可能就无法处理的那么好了。

3.翻译外文

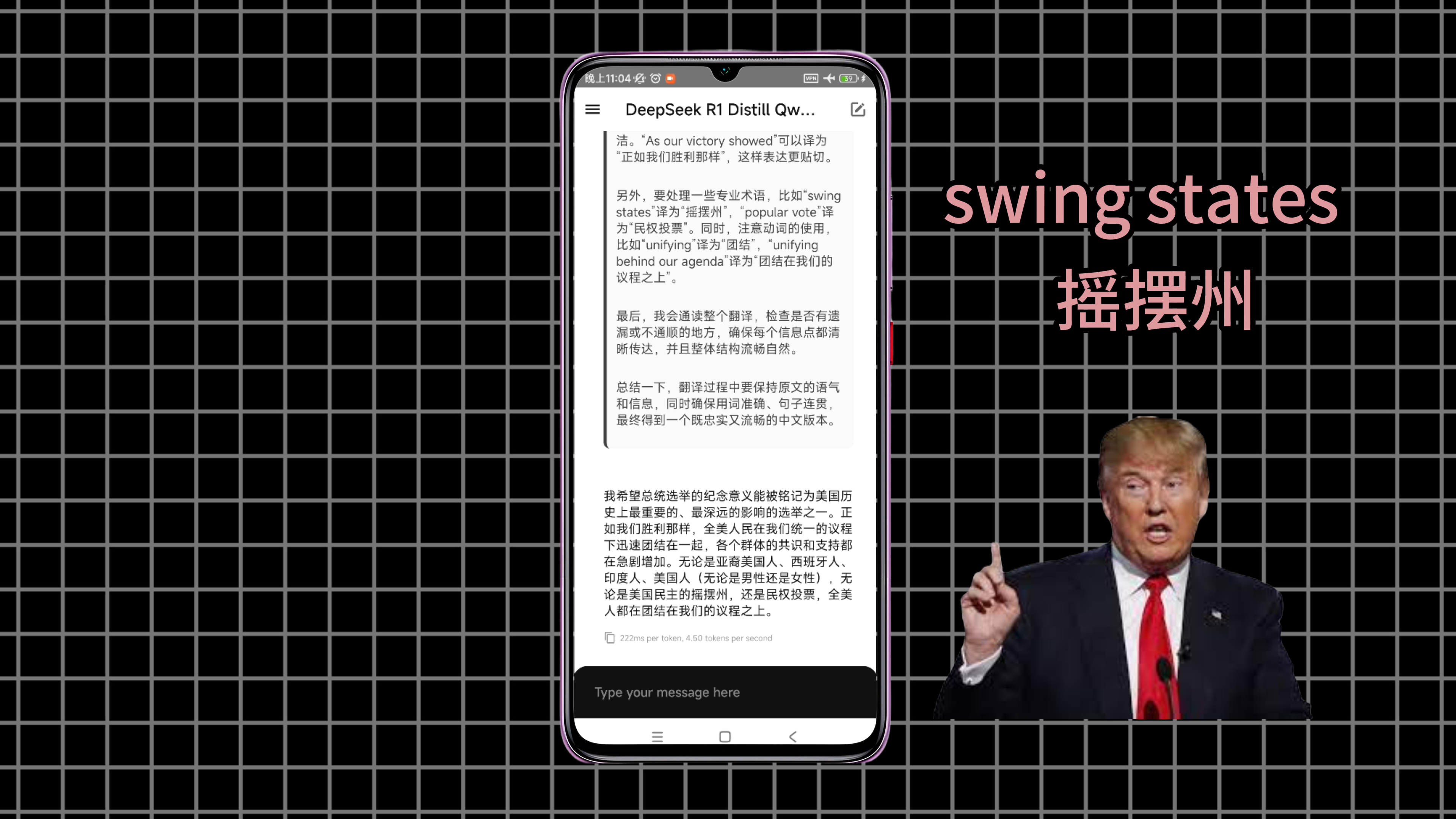

最后我们再来看一下,它翻译外文的能力。这是一段,特朗普今年,就职美国总统时的,英文演讲稿。我们让它把这段英文,翻译成中文。可以看到,它分析出了,这是一段和美国总统选举有关的,英文演讲。而且其中一些专业术语,也进行了准确的翻译。比如 swing states 翻译成了:摇摆州。翻译完成后的中文,语句之间也很流畅,基本没有问题。

结束

好了关于在手机上,部署DeepSeek R1模型,我们就介绍这些。那在手机上,部署这样一个AI模型。它的优势就是,小巧、便捷。相当于有了一个,可以放在口袋里的AI助手,随时随地都能拿出来使用。即使没有网络,也照样可以用。

同时它还是完全免费的,可以无限使用。用来处理,我们日常生活中的一些小需求,真的是非常的方便。大家如果有需要,可以按照文章的介绍,在自己的手机上,也部署一个。

文件下载

pocketpal-ai APK文件:https://pan.quark.cn/s/f0a986d9bf8b

pocketpal-ai GitHub:https://github.com/a-ghorbani/pocketpal-ai

DeepSeek R1 1.5B Q4模型文件:https://pan.quark.cn/s/2dbde83928e2

DeepSeek R1 1.5B Q8模型文件:https://pan.quark.cn/s/9b17e6cfcb37